requestId:68850125cbba21.15965598.

中國網/中國成長門戶網訊 近日,中國迷信院主動化研討所神經盤算與腦機交互(NeuBCI)課題組與中國迷信院腦迷信與智能技巧出色立異中間包養網的結合團隊聯合行動試驗與神經記憶剖析,初次證明多模態年夜說話模子(MLLMs)可以或許自覺構成與人類高度類似的物體概念表征體系。這項研討不只為人工智能認知迷信開辟了新途徑,更為構建類人認知構造的人工智能系包養網比擬統供給了實際框架。相干研討結果頒發于《天然·機械智能》。

人類可以或許對天然界中的物體停止概念化,這一認知才能持久以來被視為人類智能的焦點。當我們看到“狗”“car ”或“蘋果”時,不只能辨認它們的物理特征(尺寸、色彩、外形等),還能懂得其效能、感情價值和文明意義——這種多維度的概念表征組成了人類認知的基石。跟著ChatGPT等年夜說話模子(LLMs)的迸發式成長,一個最基礎性題目浮出水面:這些年夜模子可否從說話和多模態數據中成長出相似人類的物體概念表征?

傳統人工智能研討聚焦于物體辨認正確率,卻鮮少切磋模子能否真正“懂得”物體寄義。論文通信作者何暉光研討員指出:“以後AI能區分貓狗圖片,但這種‘辨認’與人類‘懂得’貓狗的實質差別仍有待提醒。”團隊從認知神經迷信經典實際動身,design了一套融會盤算建模、行動試驗與腦迷信的立異范式。研討采用認貼心理學經典的“三選一異類辨認義務”(triplet odd-one-out),請求年夜模子與人類從物體概念三元組(來自1854種日常概念的肆意組合)中選出最不類似的選項。經由過程剖析470萬次行動判定數據,團隊初次構建了AI年夜模子的“概念輿圖”。

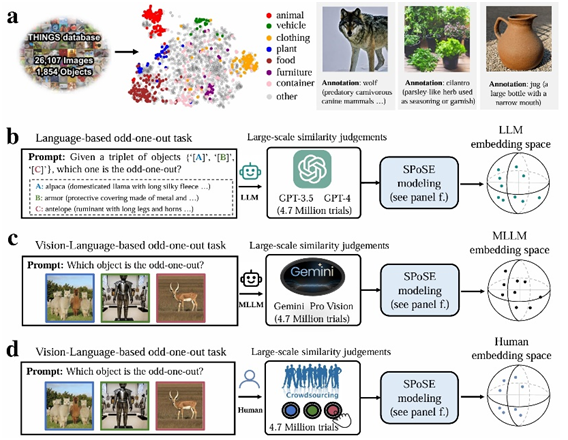

試驗范式表示圖。a,物體概念集及帶有說話描寫的圖像示例。b-d,分辨針對 LLM、MLLM 和人類的行動試驗范式和概念嵌進空間。

研討職員從海量年夜模子行動數據中提掏出66個“心智維度”,并為這些維度付與了語義標簽。研討發明,這些維度是高度可說明的,且與年夜腦種別選擇區域(如處置面貌的FFA、處置場景的PPA、處置軀體的EBA)的神經運動形式明顯相干。

研討還對照了多個模子外行為選擇形式上與人類的分歧性(Human consistency)。成果顯示,多模態年夜模子(如 Gemini_Pro_Vision、Qwen2_VL)在分歧性方面表示更優。此外,研討還提醒了人類在做決議計劃時更偏向于聯合視覺特征和語義信息停止判定,而年夜模子則偏向于依靠語義標簽和抽象概念。本研討表白年夜說話模子并非“隨機鸚鵡”,其外部存在著相似人類對實際世界概念的懂得。

主動化所副研討員杜長德為論文第一作者,何暉光包養研討員為論文通信作者。重要合包養網作者還包含腦智出色包養網中間的常樂研討員等。

TC:sugarpopular900

發佈留言